فایل robots.txt در سئو چیست؟

فایل robots.txt به شما کمک میکند، برای رباتهای گوگل و سایر موتورهای جستجو بزرگ محدودیتهایی ایجاد کنید. در ادامه متوجه میشوید فایل robots.txt چیست و سپس با همه چیز در مورد فایل robots.txt در سئو آشنا میشوید.

- robots.txt چیست؟

- چرا فایل robots.txt مهم است؟

- چگونه فایل robots.txt بسازید؟

- معرفی فایل robots.txt به گوگل

- بررسی اشتباهات و اشکالات در robots.txt

- فایل robots.txt بهتر است یا دستورالعملهای متا

- نکات پایانی در مورد فایل robots.txt

robots.txt چیست؟

- robots.txt یک فایل متنی کاملا ساده است.

- به کمک robots.txt میتوانید به موتورهای جستجو اطلاع دهید که از کرال (خزش) یک یا چندین صفحه از سایت شما خودداری کنند.

- بیشتر موتورهای جستجوی معتبر مانند گوگل، بینگ و یاهو از درخواستهای robots.txt پیروی میکنند.

چرا فایل robots.txt مهم است؟

بیشتر وبسایتها به فایل robots.txt نیاز ندارند.

چون گوگل به طور معمول توانایی پیدا کردن و ایندکس کردن تمام صفحات مهم وبسایت شما را دارد.

همچنین، به طور خودکار از ایندکس کردن صفحات غیرمهم یا نسخههای تکراری از دیگر صفحات نیز خودداری خواهد کرد.

در ادامه ۳ دلیل مهم که باید از فایل robots.txt استفاده کنید را خدمتتان عرض خواهم کرد:

۱- مسدود کردن صفحات غیر عمومی:

گاهی اوقات صفحاتی در وبسایت خود دارید که نمیخواهید ایندکس شوند. به عنوان مثال، ممکن است نسخهای تکمیل نشده از یک صفحه یا صفحه ورود به سیستم داشته باشید. این صفحات باید وجود داشته باشند، اما نمیخواهید در معرض دید کاربران سایت نیز قرار بگیرند.

این مورد یکی از مواردی است که در آن از فایل robots txt برای مسدود کردن این صفحات از سمت خزندهها و رباتهای موتورهای جستجو استفاده میکنید.

۲- افزایش بودجه خزش یا کرال:

اگر در ایندکس کردن صفحات وبسایت خود مشکل دارید، ممکن است با مشکلی در بودجه خزش روبرو شده باشید. با مسدود کردن صفحات غیر مهم با استفاده از فایل robots.txt، ربات گوگل میتواند مقدار بیشتری از بودجه خزش شما را بر روی صفحاتی که واقعاً مهم هستند، صرف کند.

۳- جلوگیری از ایندکس کردن منابع:

با اینکه کاربرد دستورالعملهای ربات متا هم مانند فایل robots.txt بوده و از ایندکس کردن صفحات جلوگیری میکند؛ اما با این دستورالعملها نمیتوانند به خوبی برای منابع چندرسانهای مانند PDF، تصاویر، صدا، ویدیو و … کاربرد داشته باشند! اینجاست که فایل robots.txt وارد عمل میشود.

خب حالا از این اطلاعات چه نتیجهای میگیریم؟

فایل robots.txt به موتورهای جستجو میگوید که از کرال کردن صفحات خاصی در وبسایت شما خودداری کنند.

شما میتوانید تعداد صفحاتی که در گوگل سرچ کنسول ایندکس شدهاند را بررسی کنید.

اگر تعداد صفحات مطابق با تعداد صفحاتی است که میخواهید ایندکس شوند، نیازی به ایجاد یک فایل robots.txt ندارید.

اما اگر این تعداد از آنچه انتظار داشتید بیشتر بوده (و شما متوجه میشوید صفحاتی در سایتتان ایندکس شدهاند که نباید ایندکس شوند)، در این صورت بهتر است که برای وبسایتتان یک فایل robots.txt ایجاد کنید.

چگونه فایل robots.txt بسازید؟

اول از همه notepad را از منوی استارت ویندوز باز کرده و یک فایل robots.txt بسازید.

فرقی ندارد که فایل robots.txt خود را به چه شکل ایجاد میکنید، از هر روشی که استفاده کنید در نهایت فرمت فایل یکسان خواهد بود:

User-agent: X

Disallow: Y

User-agent بات مشخصی است که با آن در حال مکالمه هستید.

و تمام مواردی که پس از «Disallow» آمده است، صفحات یا بخشهایی هستند که میخواهید از ایندکس شدن آن جلوگیری کنید.

در ادامه یک مثال برایتان میزنم:

User-agent: googlebot

Disallow: /images

این دستور به Googlebot میگوید که از ایندکس کردن پوشه تصاویر وبسایت شما خودداری کند.

همچنین میتوانید از نماد ستاره (*) استفاده کنید تا با همه باتهایی که به وبسایت شما میآیند، ارتباط برقرار کنید.

این مورد را نیز با ذکر مثال مینویسم:

User-agent: *

Disallow: /images

علامت «*» به تمامی اسپایدرها (خزندهها) میگوید که از کرال کردن پوشه تصاویر خودداری کنند.

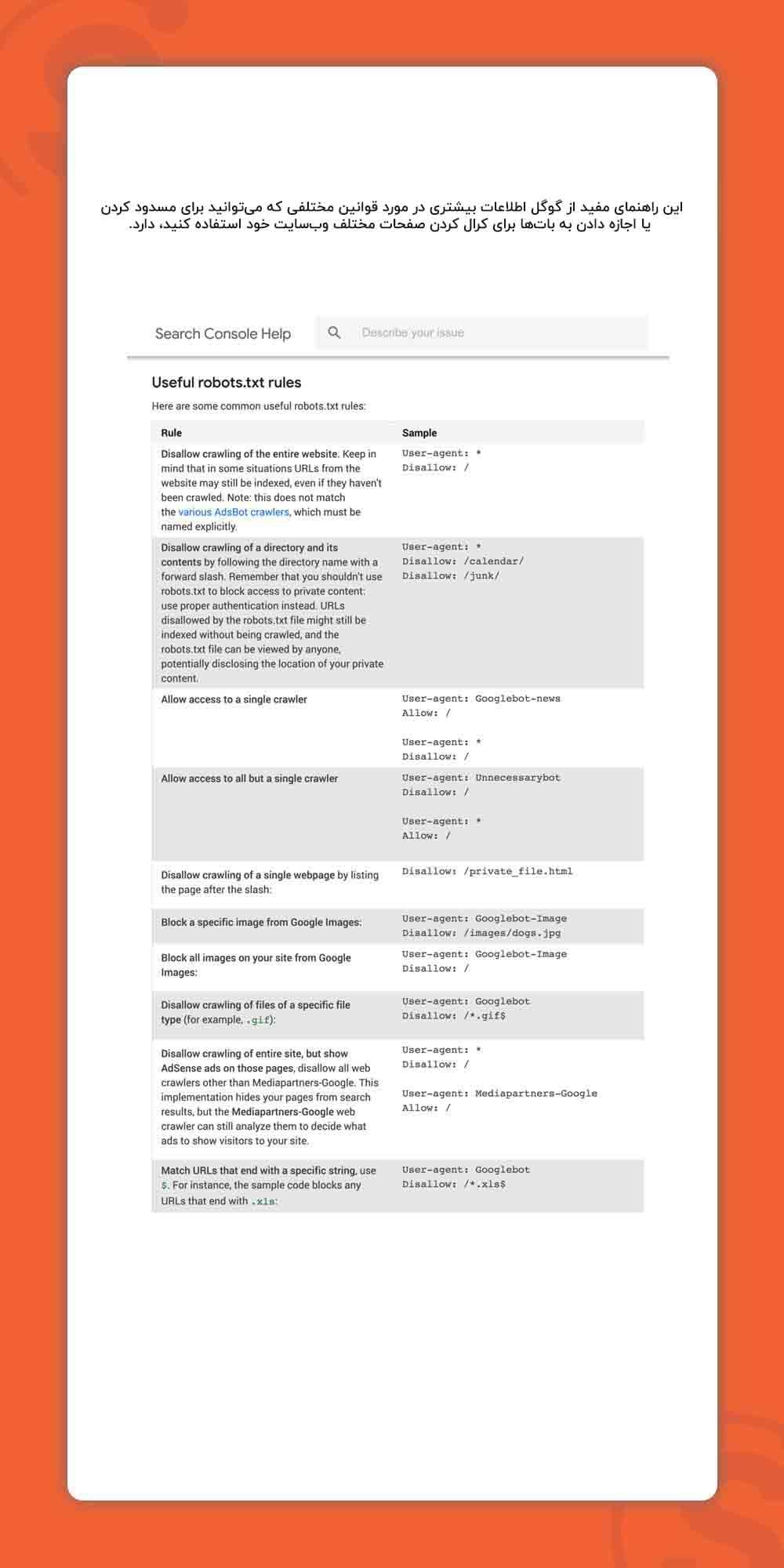

این فقط یکی از راههای استفاده از فایل robots.txt است. این راهنمای مفید از گوگل اطلاعات بیشتری در مورد قوانین مختلفی که میتوانید برای مسدود کردن یا اجازه دادن به باتها برای کرال کردن صفحات وبسایت خود استفاده کنید، دارد.

معرفی فایل robots.txt به گوگل

مسیر استاندارد فایل robots.txt در تمام وبسایتها این است:

https://example.com/robots.txt

پس از ایجاد فایل robots.txt و قراردادن در مسیر استاندارد؛ گوگل و سایر موتورهای جستجو به صورت اتوماتیک این فایل را پیدا میکنند.

(توجه داشته باشید که فایل robots.txt به بزرگی و کوچکی حروف حساس است. پس از نام فایل از حروف کوچک «r» استفاده کنید.)

در ادامه اشتباهات و مشکلاتی که ممکن است در فایل robots.txt وجود داشته باشد را برایتان توضیح خواهم داد:

بررسی اشتباهات و اشکالات در robots.txt

خیلی مهم است که تنظیمات فایل robots.txt شما به درستی انجام شده باشد. چون حتی یک اشتباه نیز میتواند منجر به حذف ایندکس کل وبسایت شما شود!

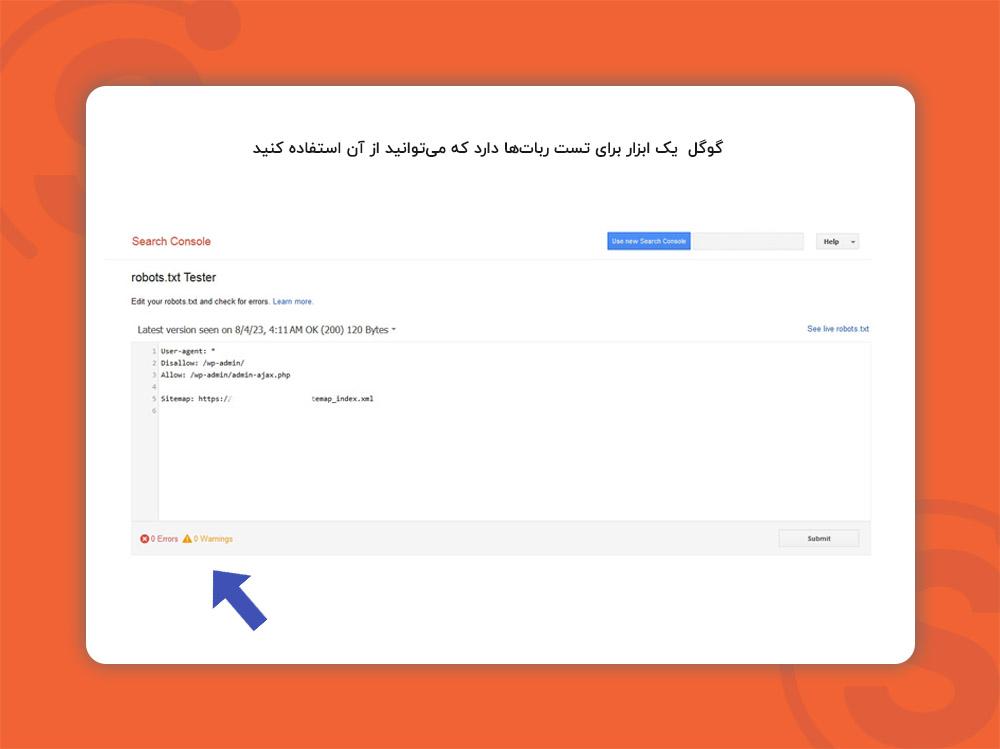

خوشبختانه، نیازی به نگرانی زیاد در این مورد نیست چون گوگل یک ابزار برای تست رباتها دارد که میتوانید از آن استفاده کنید:

همانطور که مشاهده میکنید این ابزار به شما فایل robots.txt شما را نشان میدهد و هر اشتباه و خطایی که در آن وجود داشته باشد را پیدا میکند.

فایل robots.txt بهتر است یا دستورالعملهای متا

در ادامه برایتان توضیح خواهم داد که چرا باید از فایل robots.txt استفاده کنید در حالی که میتوانید با استفاده از برچسب متا «noindex» صفحات را در سطح صفحه مسدود کنید.

همانطور که قبلاً اشاره کردم، برچسب noindex برای پیادهسازی در منابع چندرسانهای مانند ویدئوها و فایلهای PDF دشوار است.

علاوه بر این، اگر شما هزاران صفحه دارید که میخواهید مسدود کنید، اضافه کردن دستی برچسب noindex به هر صفحه به صورت جداگانه بسیار سخت و زمانبر است! راه آسانتر این است که کل بخشی از وبسایت را با استفاده از فایل robots.txt مسدود کنید.

همانطور که میدانید گوگل برای هر سایت بودجه خزش در نظر میگیرد. به همین دلیل ممکن است گاها نخواهید این بودجه صرف خزش یا کرال صفحاتی غیر مهم در سایتتان شود. اینجاست که میتوانید از فایل robots.txt استفاده کنید.

نکات پایانی در مورد فایل robots.txt

به غیر از این سه حالت، توصیه میشود به جای فایل robots.txt از دستورالعملهای ربات متا استفاده کنید. چون هم پیادهسازی آنها آسانتر است و هم احتمال ریسک (مانند مسدود کردن کل سایت شما) کمتری دارند.

برای یادگیری تخصصی و حرفهای سئو میتوانید از دوره آموزش سئو که کاملا جامع و پیشرفته است استفاده کنید.